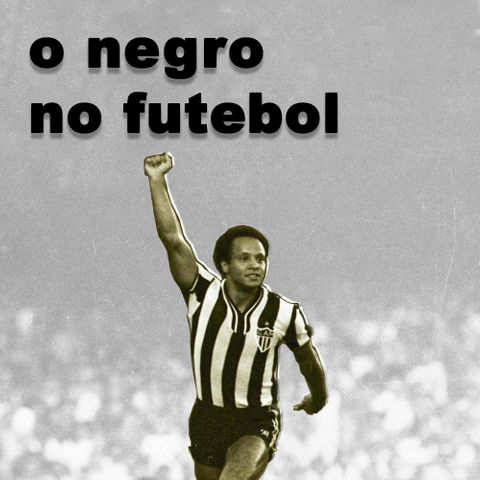

A história do futebol no brasil nos prova que não há mínima possibilidade de entender o esporte mais amado do país sem entender o próprio Brasil. A política e o futebol sempre andaram de mãos dadas por aqui. Desde que o primeiro homem negro pôs os pés no gramado, ele já estava fazendo política ao marcar a existência de corpos negros para além do campo de trabalho braçal. Num Brasil que se pretendia branco, ser um sujeito preto nos gramados em muitos casos já era um ato de rebelião.

Mas será porque os jogadores negros de destaque hoje não se posicionam politicamente?